2026年「AGI特異点」への生存戦略:コードを書くAI、責任を取る人間、そして「報酬関数」を設計するアーキテクトの不在

街中のカフェで、あるいはオフィスの会議室で、「生成AIを活用して業務を効率化しよう」という声が聞こえない日はない。猫も杓子もCopilot、何はなくともChatGPT。まるでそれが、停滞する日本企業の救世主であるかのように語られている。

だが、筆者はここで冷や水を浴びせたい。

現在、多くの企業が進めている「AI導入」の大部分は、2026年頃に到来すると予測されるAGI(汎用人工知能)やフィジカルAI(実世界で物理的に動作するAI)の本格普及を前に、無価値化する可能性が高い。なぜなら、それらは既存の業務フローを「少し速くする」だけの延命措置に過ぎないからだ。

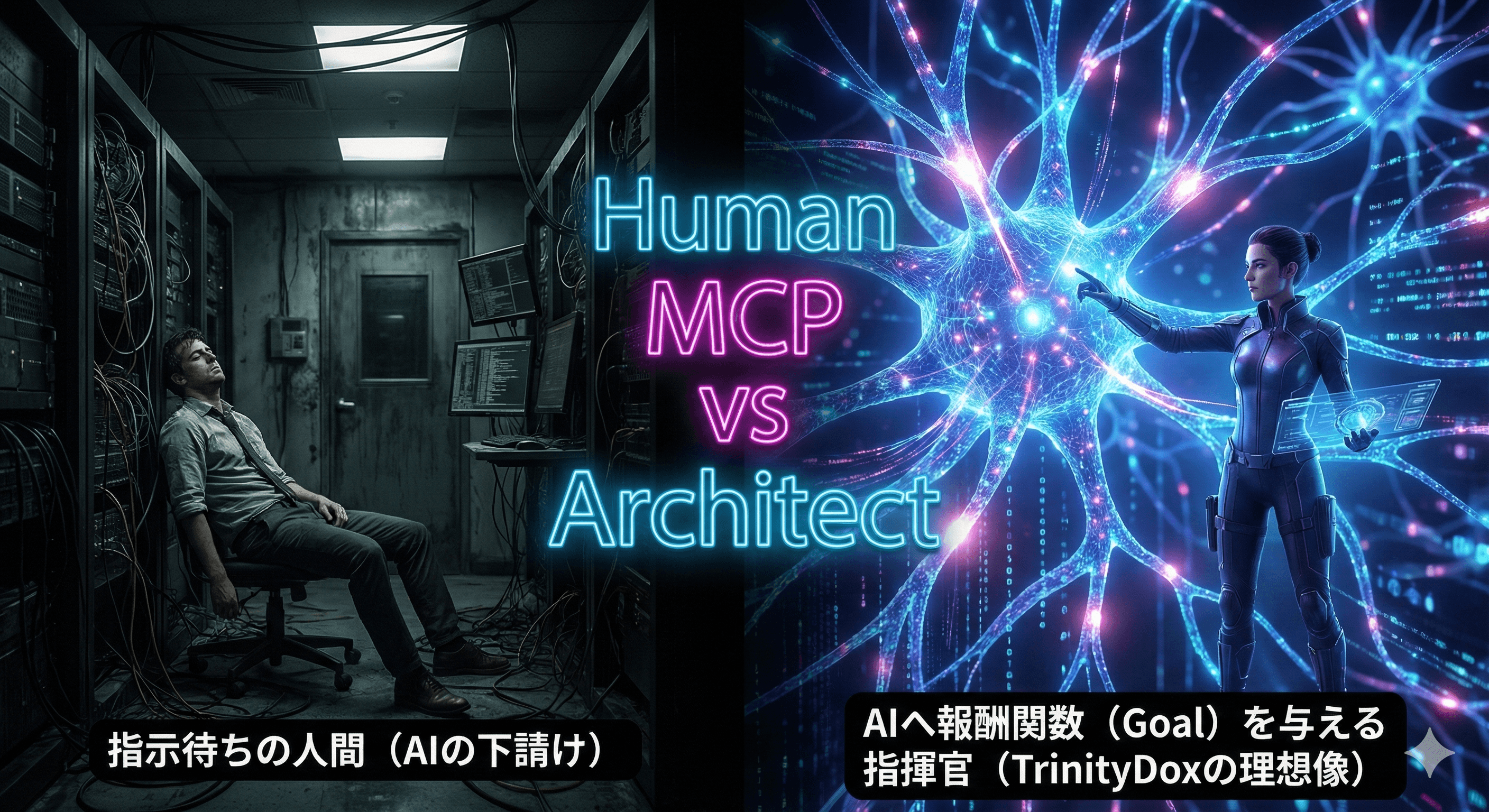

目前に迫っているのは、ツールによる効率化ではない。知的生産活動における「主客の逆転」である。コードを書くのも、データを分析してレポートを作るのも、AIが行うようになる。その時、現在の中堅エンジニアやPMが積み上げているスキルの大半は、砂上の楼閣のようにサラサラと崩れ去るだろう。

問題の本質は、個人の技術習熟度ではない。AIを単なる「便利な部下」として既存組織に組み込もうとする、経営層やリーダーの認識の甘さ、すなわち「組織的負債」にある。

今回は、来るべき2026年の特異点(シンギュラリティ)を見据え、企業が生き残るために必要な「知能のアーキテクチャ」と、そこで人間が果たすべき真の役割について論じたい。

- 構造の不協和音:マシン・マン・インターフェースの逆転

これまでのIT史を振り返れば、その構造は単純明快であった。「人間が考え、機械(システム)を操作する」。汎用機の時代から、オープン系、そしてクラウドに至るまで、この主従関係は変わっていない。人間がロジックを決定し、機械はその通りに計算資源を提供する道具に過ぎなかった。

しかし、AGIの足音と共に起きているのは、この関係の完全なる逆転である。

これからは「機械(AI)が判断し、人間が実行し、人間が責任を取る」というフェーズに突入する。たとえば、サプライチェーンの最適化をAIに委ねたとしよう。AIは膨大な変数の中から、「A社への発注を切り、B社に乗り換えることが最も利益率が高い」と冷徹に弾き出す。

ここで問われるのは、その判断を実行する際のアクションだ。長年の付き合いがあるA社の担当者に電話をかけ、「今回の発注は見送らせていただく」と告げるのは誰か。その際、相手の怒りや落胆といった感情的な摩擦(フリクション)を受け止めるのは誰か。AIではない。人間である。

筆者はこれを「マシン・マン・インターフェースの逆転」と呼びたい(マン・マシン・インターフェイスではない)。

多くの組織は、この逆転現象に耐えられない構造になっている。現場からは「AIの言うことなど聞けない」という反発が起き、経営層は「なぜAIを入れたのに成果が出ないのか」と苛立つ。現場ではギシギシと軋む音が鳴り止まない。これは個人の不手際ではなく、アーキテクチャの欠陥が生んだ不協和音だ。

AIが最適解を出し、人間がその「尻拭い」や「調整」という名のラストワンマイルを担う。この泥臭い現実を直視せず、綺麗なUIのダッシュボードだけを眺めているPMがいるとすれば、それは職務怠慢と言わざるを得ない。AI導入とは、単なるツールの導入ではなく、組織の意思決定プロセスと責任の所在を再定義する、極めて政治的かつ人間臭いプロジェクトなのである。

余談だが、かつて筆者が担当した炎上案件でも同様のことがあった。当時最先端だった自動発注システムを導入した際、現場のベテラン担当者が「機械に俺の仕事がわかるか」とデータを改ざんし、在庫の山を築いたのだ。論理的に正しいシステムも、現場の感情という「非機能要件」を設計に含めなければ、ただの産業廃棄物になる。歴史は繰り返すのである。

- 調和への論理:ローカルLLMと「報酬関数」の設計

では、この逆転した世界で、我々人間、そして企業はどう生き残るべきか。生存戦略の鍵は二つある。「知能の自給自足」と「報酬関数の設計権」だ。

まず、「知能の自給自足」について述べたい。

現在、多くの企業がOpenAIやGoogleなどの巨大テック企業が提供するAPIに依存している。しかし、これは企業の心臓部を他社に握られているに等しい。通信遅延、コストの高騰、そして何より「自社の機密データを外部に出す」というセキュリティリスクは、経営の自由度を奪う足枷となる。

これからのアーキテクトが目指すべきは、ローカルLLM(大規模言語モデル)の活用である。自社のオンプレミス環境、あるいはプライベートクラウド内に、自社固有のデータ(ドキュメント、メール、日報、設計図)を学習させた、あるいはRAG(検索拡張生成)で参照可能な小規模かつ高精度なモデルを構築するのだ。

これは、いわば「自家発電型」の知能基盤である。インターネットが遮断されても、APIの仕様変更があっても、自社の知能は動き続ける。AWS上のGPUインスタンスで自前のモデルを回し、コストと精度のバランスを自らコントロールする。この「知能の主権」を持つ企業と、持たぬ企業の格差は、2026年以降、決定的なものとなるだろう。

次に、「報酬関数の設計権」である。これが最も重要だ。

AIは「手段」を最適化することに関しては、既に人間を凌駕している。しかし、AIには決定的に欠けている能力がある。それは「目的(ゴール)」を設定することだ。AIにおける目的とは、数学的には「報酬関数(Reward Function)」として定義される。何をすればプラスの評価を与え、何をすればマイナスの評価を与えるか。この基準を決めることができるのは、人間だけである。

もし、すべてをAI任せにすれば、AIは過去のデータに基づき、「平均への回帰」を目指すだろう。リスクを避け、無難で、どこにでもある正解を出す。だが、ビジネスの突破口(ブレイクスルー)は、往々にして非合理な「妄想」や、一見無駄に見える「変なアイデア」から生まれる。

「たとえ短期的には赤字でも、この市場を取りに行く」 「データ上は不利だが、このパートナーとは心中する気概で組む」

こうした、論理を超えた意思決定こそが、企業の独自性(ユニークネス)を形作る。人間がなすべきは、AIにコードを書かせることではない。AIという強力なエンジンに対し、「どこへ向かうべきか」という報酬関数を設計し、セットすることなのだ。

- 実行の困難性とリスク:素人が陥る「責任の空白」

ここまで読まれて、「よし、ローカルLLMを導入しよう」と安易に考える読者もいるかもしれない。だが、筆者はここで釘を刺しておきたい。その実装は、生半可な覚悟では不可能だ。

ローカル環境でのLLM運用には、高度な技術的知見が求められる。どのモデル(Llama 3か、Mistralか、あるいは国産モデルか)を選定するのか。推論に必要なVRAM容量をどう見積もり、コストパフォーマンスを最大化するか。量子化(Quantization)による精度の劣化をどこまで許容するか。これらは、従来のWebアプリケーション開発とは全く異なるスキルセットを要求する。

さらに深刻なのがガバナンスの問題だ。自律的に動くAIエージェントが、誤った判断で顧客に損害を与えた場合、その責任はどうなるのか。監査ログは追跡可能か。AIの権限(Permission)は適切に分離されているか。

ここをあやふやにしたまま導入を進めれば、企業は「責任の空白」に陥る。AIが暴走した時、「AIが勝手にやりました」という言い訳は法廷では通用しない。結果、法的リスクと社会的信用の失墜という、取り返しのつかない事態を招くことになる。

「AI for Science」の領域では、研究者がAIと対話しながら仮説検証を行うプロセスが確立されつつあるが、ビジネスの現場ではまだその作法が定まっていない。素人が見様見真似で手を出せば、火傷では済まない大事故を起こす。それが、2026年のリアリティである。

まとめ:その「未来」、誰が実装するのか

2026年は、もうすぐそこにある。カレンダーを数枚めくれば、世界は一変しているだろう。AIという人類史上最強のエンジンを手に入れたとしても、それを支える強靭なシャーシ(アーキテクチャ)と、進むべき道を指し示すハンドル(戦略)がなければ、企業は猛スピードで壁に激突するだけだ。

今、貴社のプロジェクトを牽引しているのは誰か。 言われた通りのコードを書くだけの作業員か。あるいは、安全な場所から「あるべき論」を語るだけの評論家か。

もしそうなら、今すぐ体制を見直すべきだ。 必要なのは、泥臭い現場のリスクを共に背負い、技術の論理と経営の意思を「報酬関数」としてシステムに実装できる、真のアーキテクト(参謀)である。

「丸投げ」でも「内製という名の孤立」でもない、第三の道がある。それは、貴社のビジネスの文脈(コンテキスト)を深く理解し、コックピットの隣の席で、共に乱気流を乗り越えるパートナーを持つことだ。

未来は、予測するものではなく、設計するものである。 貴社のための「報酬関数」を、私と共に設計する準備はできているだろうか。