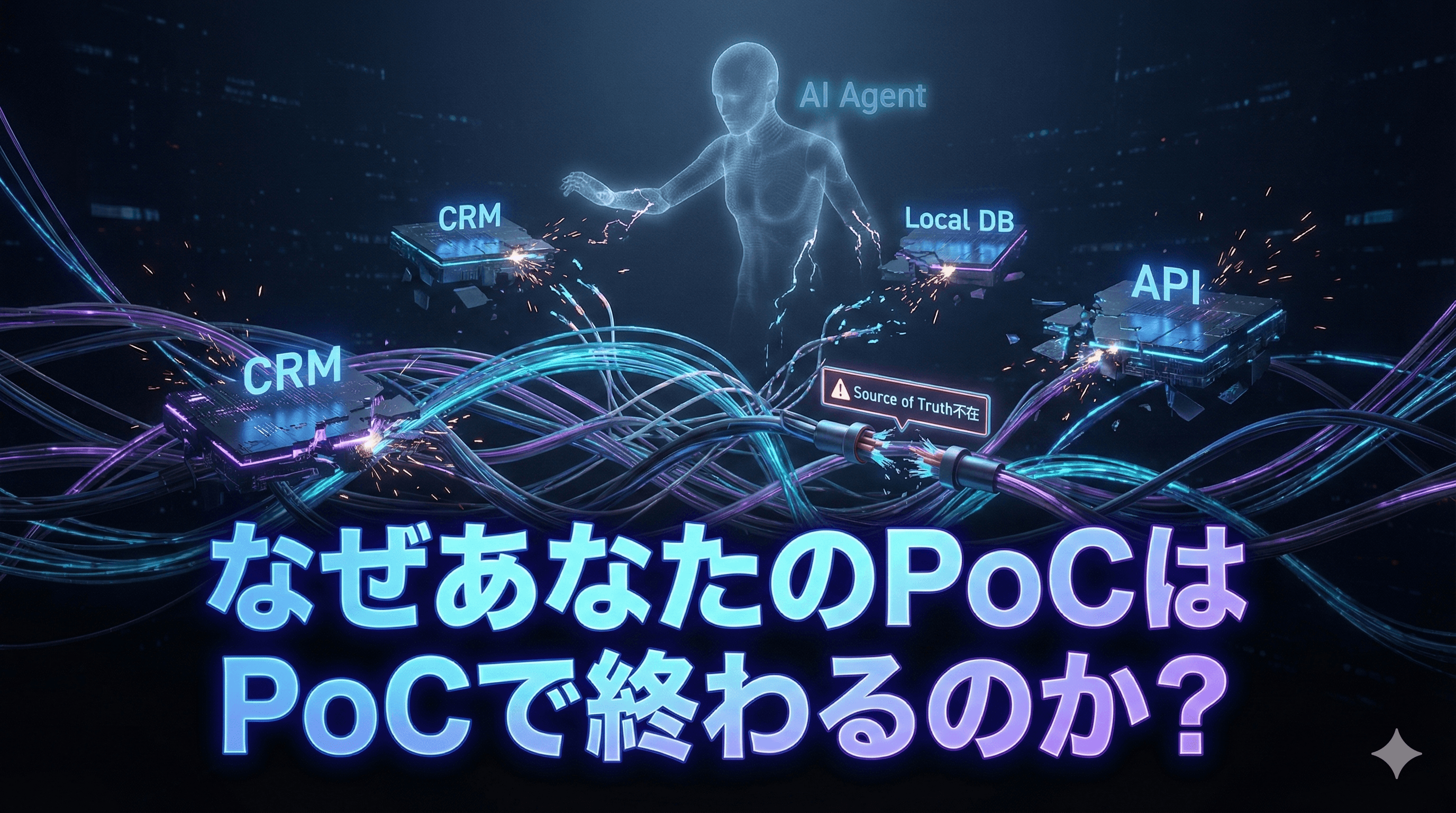

「AIエージェント」プロジェクトの8割が引き起こす、データ整合性崩壊のメカニズム:なぜあなたのPoCはPoCで終わるのか

■蜃気楼の対価

昨今、猫も杓子も「AIエージェント」である。 経営会議では「我が社も生成AIで自律的な業務遂行を」という号令が飛び交い、現場では急造のPoC(概念実証)プロジェクトが雨後の筍のごとく乱立している。

しかし、その実態はどうだろうか。

私の観測範囲、および市場のデータを俯瞰するに、AIエージェント導入プロジェクトの約8割、あるいはそれ以上が、本番運用にたどり着くことなく座礁している。

初期のデモでは滑らかに回答していたAIが、実データを食わせた途端に支離滅裂な挙動を見せ始める。あるいは、部門ごとに異なる回答を吐き出し、現場がその火消しに追われる。プロジェクトはズルズルと工数を飲み込み、最後には「時期尚早であった」という総括と共に静かに葬り去られる。ガラガラと音を立てて崩れ去る期待の残骸を、最近、私は幾度となく目にしてきた。

これは、プロンプトエンジニアリングの未熟さや、AIモデルの性能不足が原因ではない。ましてや、担当者の努力不足でもない。

断言してもいい。これは「組織構造」と「データアーキテクチャ」の欠陥がもたらす、工学的な必然である。

本稿では、なぜあなたのAIプロジェクトが失敗するのか、その構造的要因を「データ整合性の喪失」という観点から解剖する。

■整合性(Consistency)の不在

AIエージェントとは、本質的に「既存データの解釈装置」である。 人間が指示を出さずとも自律的に判断し行動するためには、その判断の根拠となるデータが、基本的に完全かつ最新で、矛盾のない状態でなければならない。

しかし、多くの企業のデータ環境は、これとは真逆の状態にある。 基幹システム(Host/AS400など)、SaaS(Salesforce, kintone)、個人のExcelファイル。データはサイロ化し、マスターデータは非正規化され、どこに「正解(Source of Truth)」があるのか、誰も定義できていない。 この状態でAIエージェントを導入することは、沼地の上に摩天楼を建てようとするに等しい行為である。

人間であれば、データの矛盾を「阿吽の呼吸」や「社内政治」で補正して業務を回すことができる。 「このマスタは更新が遅いから、経理の佐藤さんに確認しよう」といった非定型な調整プロセスこそが、実は企業のデータ整合性を担保していたのである。 AIエージェントには、その「行間」は読めない。汚れたデータを入力すれば、汚れた出力が返ってくる。ガベージイン・ガベージアウトの原則は、最新のLLMであっても覆せない物理法則である。

■スキーマ・ドリフトと依存関係

具体的に、どのような技術的欠陥がプロジェクトを破綻させるのか。以下の3つのキーワードで説明する。

- スキーマ・ドリフト(Schema Drift)への無策

ソースシステム(データ発生源)は生き物である。SaaSのフィールド定義が変更されたり、CSVの列順が変わったりすることは日常茶飯事だ。これを「スキーマ・ドリフト」と呼ぶ。 多くのPoCでは、この変化を検知・吸収する層(レイヤー)が欠落している。結果、上流の些細な変更がAIエージェントの入力定義を破壊し、システム全体が機能不全に陥る。 - 依存関係の逆転原則の無視

ソフトウェア設計の基本原則に「依存関係逆転の原則(DIP)」がある。詳細には立ち入らないが、要は「上位モジュールは下位モジュールの詳細に依存してはならない」という教えだ。 失敗するプロジェクトでは、AIエージェントが特定のデータベース構造やAPIの仕様に「ベタ書き」で依存している。これでは、システムの柔軟性は失われ、保守コストは幾何級数的に増大する。抽象化されたデータ提供層を挟まないアーキテクチャは、早晩、自重に耐えきれず倒壊する。 - 振り付け(Choreography)なきオーケストレーション

複数のAIエージェントを連携させる際、それぞれの役割とデータの受け渡し順序を厳密に定義せず、「なんとなく良きに計らってくれる」ことを期待するケースが散見される。 これは、指揮者のいないオーケストラのようなものだ。各エージェントが勝手なタイミングでデータを書き換えれば、データの整合性は瞬時に失われる。必要なのは、厳格なステート管理と、冪等性(何度実行しても結果が変わらない性質)を担保したパイプライン設計である。

■歴史は繰り返す

ここで少し、時計の針を戻そう。 1990年代、クライアント・サーバー・システムが台頭した際も、同様の混乱があったと記憶している。メインフレームによる中央集権的な統制から解放された部門サーバー群は、瞬く間に「データの孤島」を生み出した。 当時の我々は、EAIツールや夜間バッチ処理を駆使し、スパゲッティのように絡み合ったデータを必死で繋ぎ合わせようとしたものである。 (筆者注・当時のデスマーチの記憶は、今も胃をキリキリとさせる)

現在の「AIブーム」裏で起きていることは、本質的に当時と変わらない。 ツールがSQLから自然言語に変わっただけで、我々はまたしても「統制なき分散」という過ちを繰り返そうとしている。 歴史を知らぬ者は、同じ石に躓く。AIという「魔法の杖」が、泥臭いデータ整備の必要性を消し去ってくれるわけではないのだと、筆者は考える。

■データパイプラインの再設計

では、どうすればよいのか。 答えはシンプルだ。

「データパイプラインを正しく設計し、実装する」。これに尽きる。

AIエージェント導入の前に、あるいは並行して、以下の施策を断行する必要がある。

- Source of Truth(信頼できる唯一の情報源)の定義

どのデータが「正」なのか。それを誰が管理するのか。RACIチャート(役割分担図)を用いて定義し、システム的に強制力を働かせる。 - 抽象化レイヤーの設置

AIエージェントがソースシステムに直接触れることを禁止する。DWH(データウェアハウス)やデータレイク上に、AI利用に最適化されたビュー(データマート)を用意し、そこを通じてのみデータを提供する。これにより、スキーマ・ドリフトの影響を局所化できる。 - オブザーバビリティ(可観測性)の確保

データがどこで発生し、どう加工され、AIに渡ったか。その系譜(リネージ)を追跡可能な状態にする。エラーが起きた際、原因がデータにあるのかモデルにあるのかを即座に判別できなければ、運用は回らない。

これらのデータ基盤整備を「面倒だ」「AIのスピード感が削がれる」と敬遠する現場があることは承知している。 しかし、基礎工事を省略したビルがどうなるか、想像に難くないだろう。このデータ整合性の問題を、現場のエンジニアの「頑張り」や手作業でカバーしようとする行為は、工学的に見て不可能である。

■まとめ:アーキテクトとしての選択

最後に、本稿の要点を整理する。

- AIエージェントの失敗要因は、AIそのものではなく、組織のデータ整合性の欠如にある。

- スキーマ・ドリフトや依存関係の整理を怠れば、システムは必ず破綻する。

- 解決策は、抽象化レイヤーを含む堅牢なデータパイプラインの構築のみである。

我々(アーキテクト)の役割は、夢物語を語ることではない。物理法則と論理に従い、倒壊しない構造物を設計することだ。

整合性の取れたAIエージェントを設計し直すか、このままPoC地獄で徒労に終わるか。選択肢は多くない。

技術の進化は早いが、それを支える論理の骨格は、あまり変わらないのである。